博文

基于样本特征解码约束的GANs

|

引用本文

陈泓佑, 陈帆, 和红杰, 朱翌明. 基于样本特征解码约束的GANs. 自动化学报, 2022, 48(9): 2288−2300 doi: 10.16383/j.aas.c190496

Chen Hong-You, Chen Fan, He Hong-Jie, Zhu Yi-Ming. A GANs model based on sample feature decoding constraint. Acta Automatica Sinica, 2022, 48(9): 2288−2300 doi: 10.16383/j.aas.c190496

http://www.aas.net.cn/cn/article/doi/10.16383/j.aas.c190496

关键词

生成式对抗网络,梯度消失,特征学习,自动编码机,深度学习

摘要

生成式对抗网络(Generative adversarial networks, GANs)是一种有效模拟训练数据分布的生成方法, 其训练的常见问题之一是优化Jensen-Shannon (JS)散度时可能产生梯度消失问题. 针对该问题, 提出了一种解码约束条件下的GANs, 以尽量避免JS散度近似为常数而引发梯度消失现象, 从而提高生成图像的质量. 首先利用U-Net结构的自动编码机(Auto-encoder, AE)学习出与用于激发生成器的随机噪声同维度的训练样本网络中间层特征. 然后在每次对抗训练前使用设计的解码约束条件训练解码器. 其中, 解码器与生成器结构相同, 权重共享. 为证明模型的可行性, 推导给出了引入解码约束条件有利于JS散度不为常数的结论以及解码损失函数的类型选择依据. 为验证模型的性能, 利用Celeba和Cifar10数据集, 对比分析了其他6种模型的生成效果. 通过实验对比Inception score (IS)、弗雷歇距离和清晰度等指标发现, 基于样本特征解码约束的GANs能有效提高图像生成质量, 综合性能接近自注意力生成式对抗网络.

文章导读

生成式对抗网络(Generative adversarial networks, GANs)是2014年 Goodfellow等[1]依据零和博弈思想和纳什均衡原理提出的一种数据生成模型, 被广泛应用于图像生成领域. GANs在网络结构上主要由生成器G网络和判别器D网络组成[1-3]. G网络的目的是将随机噪声映射到训练集分布中, 对随机噪声和训练数据的联合概率密度进行建模, 关注于数据生成过程. D网络的目的是区分出馈入样本的类别问题, 关注于生成数据和训练数据的最优分界面. GANs的最大特点是对抗学习方式, 训练过程中G网络和D网络交替对抗训练, 两者的能力同步提升.

由于GANs在图像数据生成上的出色表现, 此后为提高GANs生成图像的多样性(模式坍塌问题)和质量等, 研究者提出了许多GANs衍生模型.

从加入条件变量和图像隐码控制方面进行改进. Mirza等[4]提出的条件生成式对抗网络尝试利用训练集样本的某些信息(如图像类别标签)来提高随机噪声zz的可解释性, 使得生成图像质量有所提高. Odena[5]提出的半监督学习生成式对抗网络将GANs进行拓展, 利用半监督学习使得D网络分类能力提高, 能够有效提高生成图像质量及收敛速度. Odena等[6]提出的辅助分类器生成式对抗网络可实现多分类问题, 输出的则是对应标签的概率值, 有效提高了GANs模型模拟多类别、高分辨率数据集的效果. Chen等[7]提出的信息极大化生成式对抗网络在GANs对抗学习的基础上, 通过引入一个训练集样本对应的隐含信息(如类别标签, 倾斜度), 使得隐含信息与生成样本具有较高的互信息, 有效提高图像生成质量. Donahue等[8]提出双向生成式对抗网络 (Bidirectional generative adversarial networks, BiGANs)是一种双向结构的对抗模型, 增加了一个训练好的编码器E 网络用于提取训练样本隐码c, 在D网络的馈入信息是随机噪声z与对应生成样本配对或样本隐码c与对应的训练样本配对, 在生成实际场景图像上能取得很好的效果. 以上GANs中对于需要标签信息的GANs模型限制了其在无监督对抗学习中的应用. 双向生成式对抗网络中隐码的引入使得训练样本反复被编码器编码, 而且馈入到D网络的数据不仅仅是图像样本, 还有隐码c, 整个GANs网络框架变得更复杂, 增加训练代价.

从GANs网络结构或框架设计方面进行改进. Radford等[9]提出的深度卷积生成

式对抗网络(Deep convolutional generative adversarial networks, DCGANs)使用重新设计的卷积神经网络作为G和D网络, 能够有效提高图像生成质量, 并且成为GANs网络结构设计上的标准模型之一. Denton等[10]提出的一种拉普拉斯金字塔生成式对抗网络模型, 结合GANs和条件GANs的一些优点, 使用多个GANs逐层地生成高质量自然图像. Brock等[11]基于残差网络设计的大型生成式对抗网络能有效生成大尺寸, 高质量的自然图像, 但参数量明显大于一般GANs模型, 需要更多的硬件资源和时间成本. Nguyen等[12]提出的双判别器生成式对抗网络使用两个D网络更细化GANs中D网络的分类任务, 能使得训练收敛速度变快及提高生成图像的多样性. 张龙等[13]提出一种协作式结构的GANs模型提高生成图像质量, 一定程度避免了模式坍塌现象的发生. GANs网络结构的设计通常难度较大, 这也是到目前为止, 通过结构设计提升GANs能力的经典GANs模型很少的主要原因.

从优化目标函数梯度消失方面进行改进. GANs优化Jensen-Shannon (JS)散度时可能导致梯度消失, 使得训练效果相对较差, 多样性不足[14]. 研究者主要是使用其他散度代替JS散度. Arjovsky等[14]提出沃瑟斯坦距离生成式对抗网络, 利用沃瑟斯坦距离来描述作为两个分布的相似度; 这有效避免了优化JS散度容易出现的梯度消失现象, 但对D网络权重剪枝比较粗暴. Mao等[15]提出的最小二乘生成式对抗网络(Least squares generative adversarial networks, Least squares GANs或LSGANs)是利用最小二乘原理, 将G和D网络的损失函数设计成最小二乘形式, 使得GANs优化生成数据分布和训练数据分布的Pearson散度, 避免梯度消失, 并且损失函数收敛过程更平稳. Berthelot等[16]提出的边界平衡生成式对抗网络(Boundary equilibrium generative adversarial networks, BEGANs)将一个自编码器作为D网络, 设计了G和D网络的平衡度量方法来优化沃瑟斯坦距离, 进而引入新的超参数来平衡两个网络训练, 以期得到更好的生成图像. Gulrajani等[17]提出的梯度惩罚沃瑟斯坦距离生成式对抗网络(WGANs with gradient penalty, WGANsGP), Wu等[18]提出的沃瑟斯坦散度生成式对抗网络均是WGANs的改进模型, 其中WGANsGP通过梯度惩罚的方式替换掉权重剪切, 从而避免因权重剪切导致的权重集中化和调参上的梯度消失问题. 沃瑟斯坦散度生成式对抗网络通过引入沃瑟斯坦散度, 从而去除WGANs中D网络的Lipschitz条件, 又能保留沃瑟斯坦距离度量两个分布的良好性质(如JS散度的梯度消失问题). Su[19]提出的对偶GANs模型, 通过引入合理的概率散度并找出它的对偶表达, 再将其转化成极小−极大博弈形式, 从而避免了类似于WGANs需要的Lipschitz条件和多数GANs容易发生梯度消失问题. Zhao等[20]提出基于能量的生成式对抗网络是将D网络看成能量函数, 提供了一种基于能量解释的GANs, 并且通过pull-away term策略来防止梯度消失问题导致的模式坍塌. 王功明等[21]等提出一种基于重构误差能量函数的GANs模型, 利用深度置信网络作为G网络, 能预防网络梯度消失, 在生成效果和网络学习效率上有所提升. 这些方法虽然能有效解决梯度消失问题, 但普遍需要比较多的迭代次数, 特别是优化沃瑟斯坦距离的GANs, 通常为使得D网络满足1-Lipschitz条件, 每个批次的训练中很可能需要对其进行多次训练.

除此之外还有其他的改进途径. Qi[22]提出的损失敏感型生成式对抗网络主要为了限制GANs试图模拟任意训练集分布的能力, 让生成模型能够更偏向于改进真实度不高的样本从而提高图像生成效果. Zhang等[23]提出的自注意力生成式对抗网络 (Self-attention generation adversarial networks, SAGANs), 利用注意力机制嵌入G网络和D网络中, 使得两个网络能更好地学习网络自发关注的训练图像特征提高了生成图像质量和多样性, 但其网络规模和训练迭代次数有所增加.

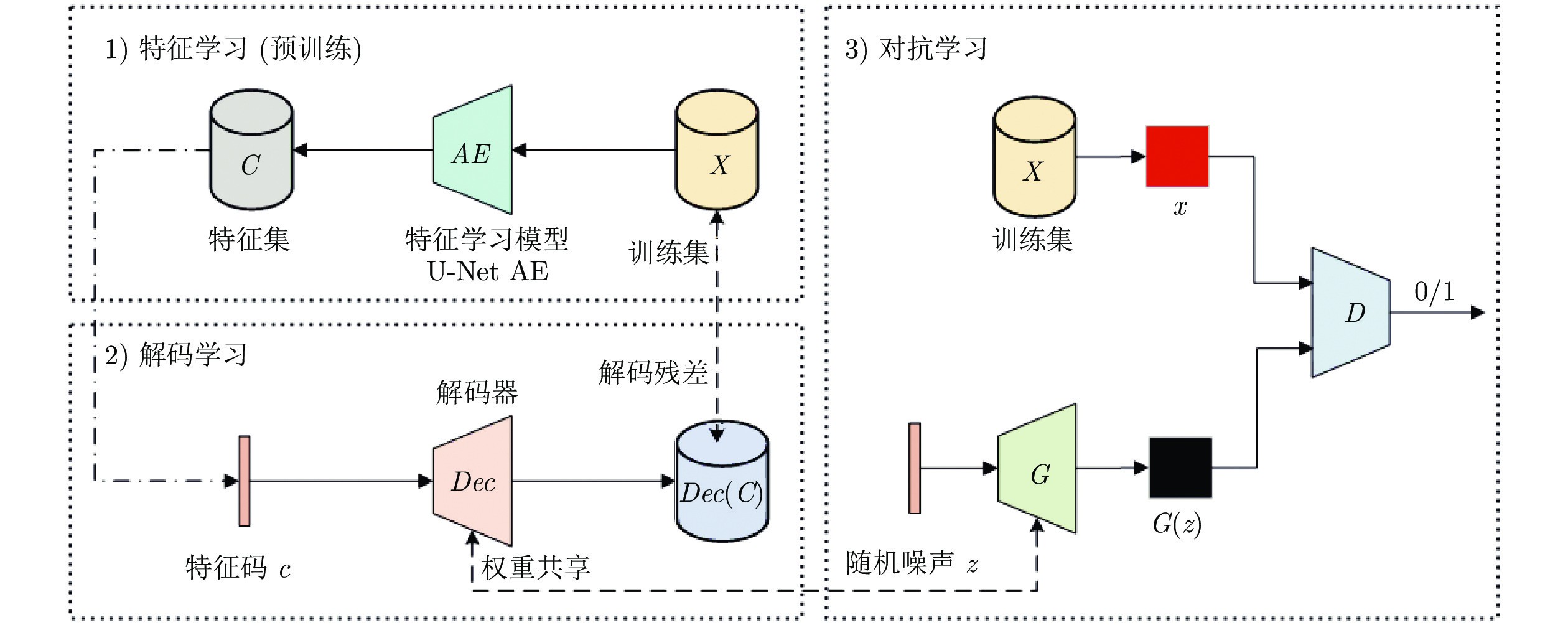

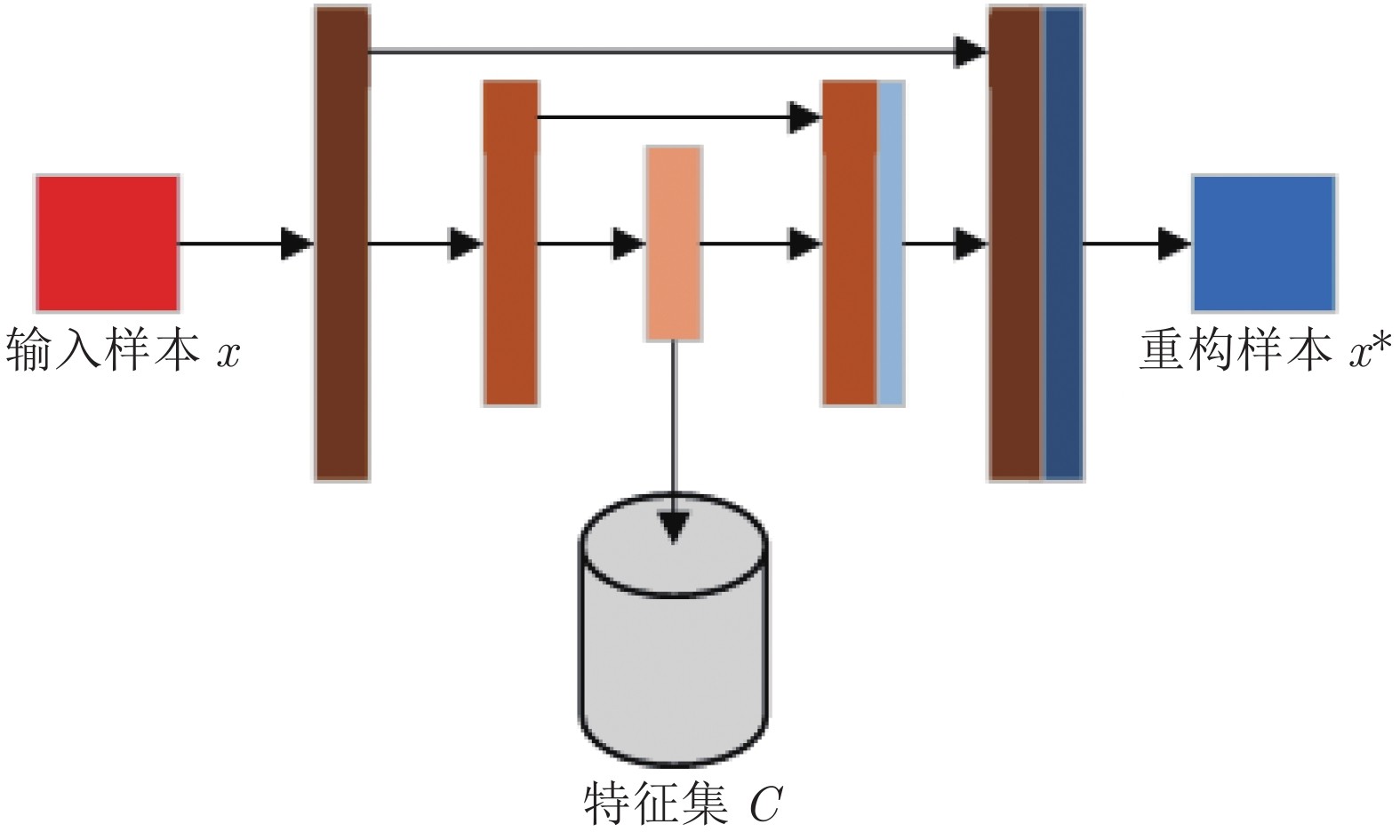

考虑到优化JS散度容易带来的梯度消失问题, 无监督GANs模型在训练上更便利的优点. 本文依然将JS散度作为主优化目标的前提下, 提出了一种基于训练集样本特征解码损失约束的无监督GANs模型. 所设计的模型不仅尽量避免优化JS散度可能带来的梯度消失问题, 同时也通过改进GANs网络拓扑结构, 融入样本本身的特征信息进行训练以提高GANs图像生成能力. 首先利用无监督特征学习模型预训练出训练集样本的中间层特征; 然后构建一个与G网络结构一致和权重共享的解码器Dec, 在每次对抗训练前使用本文设计的约束条件进行图像特征解码; 最后再进行优化JS散度的GANs对抗学习. 为验证所设计的GANs性能, 利用Celeba和Cifar10数据集, 对比分析了几种典型GANs模型的生成效果. 实验结果表明, 本文方法能有效提高生成图像的多样性和质量的同时, 还能减少训练所需的epoch数.

图1 总体结构示意图

图2 特征学习网络结构图

为提高GANs图像生成质量, 考虑到JS散度可能为近似常数时带来对生成图像效果的不利影响, 本文尝试通过增加样本特征解码约束条件来减弱这些影响. 实验结果表明, 利用样本特征解码约束条件进行对抗训练的约束, 有利于图像生成质量提高和减少epoch数. 同时, 本文方法能够更合理地模拟训练集的高频信息部分. 本文方法需对训练样本预学习出样本特征, 虽较少地增加了网络参数量, 但需要较多的特征提取预训练时间. 对于其他特征提取方法, 特征分布与随机噪声分布的关系对生成效果的影响值得进一步研究.

作者简介

陈泓佑

西南交通大学信息科学与技术学院博士研究生. 主要研究方向为机器学习和图像处理.E-mail: chy2019@foxmail.com

陈帆

西南交通大学信息科学与技术学院副教授. 主要研究方向为多媒体安全和计算机应用.E-mail: fchen@home.swjtu.edu.cn

和红杰

西南交通大学信息科学与技术学院教授. 主要研究方向为图像取证和图像处理. 本文通信作者.E-mail: hjhe@home.swjtu.edu.cn

朱翌明

西南交通大学信息科学与技术学院硕士研究生. 主要研究方向为深度学习和图像处理.E-mail: swjtu163zym@163.com

https://blog.sciencenet.cn/blog-3291369-1356786.html

上一篇:基于事件触发的AUVs固定时间编队控制

下一篇:基于WCGAN的矿物浮选泡沫图像光照不变颜色提取